DSS部署在bigdata4节点上。

1.1下载安装包地址:

版本:1.1.1

确保安装的系统为CentOS为6或者7

服务器存在多网卡问题。首先通过命令ifconfig命令查看服务器激活状态的网卡,若激活状态的网卡数大于1,那么用户就需要通过命令ifconfig[NIC_NAME]down([NIC_NAME]为网卡名称)来关闭多余的网卡,以确保激活的网卡数只有1个

网卡多IP问题。在确保服务器只存在一个网卡是激活状态的情况下,通过命令echo$(hostname-I)查看网卡对应的IP数,若大于1,那么就需要去掉网卡中指定的IP,采用动态获取IP的方式,具体命令如下:ipaddrflushdev[NIC_NAME]

ifdown[NIC_NAME]

ifup[NIC_NAME]

hostname配置。在安装前用户需要配置hostname到ip的映射

1.3基础软件安装1.3.1概述需要的命令工具(在正式安装前,脚本会自动检测这些命令是否可用,如果不存在会尝试自动安装,安装失败则需用户手动安装以下基础shell命令工具):

telnet;tar;sed;dos2unix;mysql;yum;java;unzip;zip;expect

需要安装的软件:

MySQL(5.5+);JDK(1.8.0_141以上);Python(2.x和3.x都支持);Nginx

下面的服务必须可从本机访问:

Hadoop(2.7.2,Hadoop其他版本需自行编译Linkis),安装的机器必须支持执行hdfsdfs-ls/命令

Hive(2.3.3,Hive其他版本需自行编译Linkis),安装的机器必须支持执行hive-e“showdatabases”命令

Spark(支持2.0以上所有版本),安装的机器必须支持执行spark-sql-e“showdatabases”命令

Tips:

如用户是第一次安装Hadoop,单机部署Hadoop可参考:Hadoop单机部署;分布式部署Hadoop可参考:Hadoop分布式部署

如用户是第一次安装Hive,可参考:Hive快速安装部署

如用户是第一次安装Spark,OnYarn模式可参考:SparkonYarn部署

_64_64yum-yinstallsedyuminstall-ydos2unixyum-yinstallexpect1.3.2.2如果用户的Pyspark想拥有画图功能,则还需在所有安装节点,安装画图模块

python-mpipinstallmatplotlib1.3.2.3MySQL安装

①.在bigdata4节点上,安装

下载地址:

②.上传并解压解压_64.

2.解压:_64.更改名称_64设置3306端口port=3306设置mysql数据库的数据的存放目录datadir=/opt//data允许连接失败的次数。这是为了防止有人从该主机试图攻击数据库系统max_connect_errors=10创建新表时将使用的默认存储引擎default-storage-engine=INNODB设置mysql客户端默认字符集default-character-set=utf8[client]MYSQL_HOME

exportMYSQL_HOME=/opt/

exportPATH=$PATH:$MYSQL_HOME/bin让环境变量生效source/etc//my_

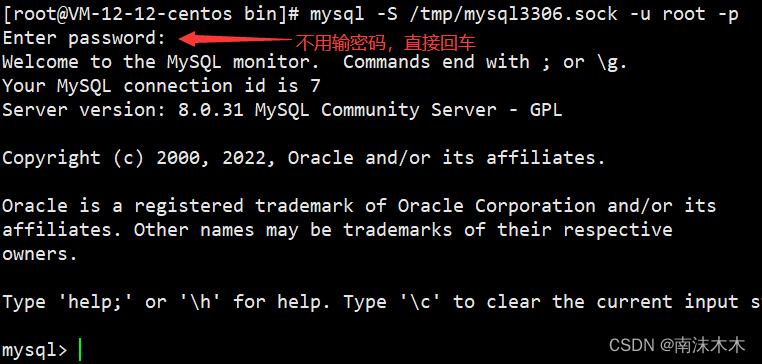

⑧.登录数据库

mysql-uroot-p

⑨.修改密码

flushprivileges;ALTERUSER'root'@'localhost'IDENTIFIEDBY'root'PASSWORDEXPIRENEVER;ALTERUSER'root'@'localhost'IDENTIFIEDwITHmysql_native_passwordBY'Xl123456';flushprivileges;1.3.2.4Nginx安装①.在bigdata4节点上,安装

下载地址:②.上传并解压解压

2.解压:更改用户组sudochown-Radmin:/③.安装nginx

用户需要对/opt/dss_linkis/conf目录下的和进行修改。

修改

vim/opt/dss_linkis/conf/修改文件内容如下:

Linkis_VERSIONLINKIS_VERSION=1.1.1DSSVERSIONDSS_VERSION=1.1.1linkis的其他默认配置信息startGenerallylocaldirectoryfile://requiredWORKSPACE_USER_ROOT_PATH=/home/admin/linkisPathtostorejobResultSet:fileorhdfspathhdfs://requiredRESULT_SET_ROOT_PATH=hdfs:///tmp/linkisENTRANCE_CONFIG_LOG_PATH=hdfs:///tmp/linkis/hdfs://required/appcom/config/hadoop-configHADOOP_CONF_DIR=/opt//etc/hadoop/appcom/config/hive-configHIVE_CONF_DIR=/opt/hive/conf/appcom/config/spark-configSPARK_CONF_DIR=/opt/hive/confNOTICE:servicesServiceRegistrationDiscoveryCenterLINKIS_EUREKA_INSTALL_IP=127.0.0.1LINKIS_EUREKA_PORT=9600GatewayinstallinformationApplicationManagerEngineManagerEnginePluginServerLinkisEntrancepublicservicecsNOTICE:_SERVERproject-serverDSS_FRAMEWORK_PROJECT_SERVER_PORT=9002DSS_FRAMEWORK_ORCHESTRATOR_SERVER_INSTALL_IP=127.0.0.1apiservice-serverDSS_APISERVICE_SERVER_PORT=9004DSS_WORKFLOW_SERVER_INSTALL_IP=127.0.0.1dss-flow-execution-serverDSS_FLOW_EXECUTION_SERVER_PORT=9006DSS_SCRIPTIS_SERVER_INSTALL_IP=127.0.0.1dss-data-api-serverDSS_DATA_API_SERVER_PORT=9208DSS_DATA_GOVERNANCE_SERVER_INSTALL_IP=127.0.0.1dss-guide-serverDSS_GUIDE_SERVER_PORT=9210DSS微服务配置完毕SavethefilepathexportedbytheorchestratorserviceORCHESTRATOR_FILE_PATH=/home/admin/dssforDSS-ServerandEventcheckerAPPCONNMYSQL_HOST=172.16.3.26MYSQL_PORT=3306MYSQL_DB=dssMYSQL_USER=rootMYSQL_PASSWORD=Xl123456HiveMeta元数据库的URLHIVE_META_URL=jdbc:mysql://172.16.3.26:3306/metastore?useSSL=falseuseUnicode=truecharacterEncoding=UTF-8HiveMeta元数据库的密码HIVE_META_PASSWORD=Xl1234561.5安装和使用1.5.1停止机器上所有DSS及Linkis服务若从未安装过DSS及Linkis服务,忽略此步骤

1.5.2将当前目录切换到bin目录cd/opt/dss_linkis/bin1.5.3执行安装脚本该安装脚本会检查各项集成环境命令,如果没有请按照提示进行安装,以下命令为必须项:

yum;java;mysql;unzip;expect;telnet;tar;sed;dos2unix;nginx安装时,脚本会询问您是否需要初始化数据库并导入元数据,Linkis和DSS均会询问,第一次安装必须选是

通过查看控制台打印的日志信息查看是否安装成功,如果有错误信息,可以查看具体报错原因

除非用户想重新安装整个应用,否则该命令执行一次即可

1.5.4启动服务若用户的Linkis安装包是通过自己编译获取且用户想启用数据源管理功能,那么就需要去修改配置以启动该项功能,使用下载的安装包无需操作

打开配置文件切换目录到dss,正常情况下dss目录就在xx/dss_linkis目录下,cd/opt/dss_linkis/dss/bin#执行启动默认Appconn脚本该命令执行一次即可,除非用户想重新安装整个应用

1.5.6查看验证是否成功用户可以在Eureka界面查看LinkisDSS后台各微服务的启动情况,默认情况下DSS有7个微服务,Linkis有10个微服务(包括启用数据源管理功能后的两个微服务)(Eureka地址在xx/dss_linkis/conf/有配置)

用户可以使用谷歌浏览器访问以下前端地址:http://DSS_NGINX_IP:DSS_WEB_PORT启动日志会打印此访问地址(在xx/dss_linkis/conf/中也配置了此地址)。登陆时默认管理员的用户名和密码均为部署用户为hadoop(用户若想修改密码,可以通过修改/opt/dss_linkis/linkis/conf/文件中的参数)

1.5.7停止服务sh/opt/dss_linkis/bin/若用户需要停止所有服务可执行该命令,重新启动所有服务就执行,这两条命令均在xx/dss_linkis/bin目录下执行

1.6补充说明考虑到安装包过于大的问题,Linkis默认仅提供Hive,Python,Shell,Spark引擎插件,用户若想使用其他引擎,可参考文档:Linkis引擎的安装

DSS默认未安装调度系统,用户可以选择安装Schedulis或者DolphinScheduler,具体安装方式见下面表格

DSS默认仅安装DateChecker,EventSer,EventReceiverAppConn,用户可参考文档安装其他AppConn,如Visualis,Exchangis,Qualitis,Prophecis,Streamis。调度系统可使用Schedulis或DolphinScheduler

1.7web端访问地址:地址:

账号:admin

密码:hadoop1.8官网文档地址

欢迎进入开发者交流群,以下学习资料有助于你了解WDS:

(1)沙箱环境使用指南:

(3)使用DSS实现可视化BI:

(4)技术文章集锦:如果你们有培训、安装部署、运维支持等商业合作的需求,欢迎联系小助手进行详细沟通

1.9常见问题:1.9.1启动服务报错